Để tạo ra AI thông minh hơn, các nhà nghiên cứu đang cần những giải pháp huấn luyện mới

Những startup và đơn vị nghiên cứu AI nổi bật nhất trên thị trường hiện nay đang phải tìm ra những cách mới để huấn luyện cũng như đánh giá sức mạnh của những mô hình ngôn ngữ AI thế hệ mới, một phần của những nỗ lực giúp trí tuệ nhân tạo có thể mô phỏng cách bộ não con người suy nghĩ.

Trao đổi với Reuters, nhiều nhà nghiên cứu AI đã cho biết, những kỹ thuật mới đã được ứng dụng trong quá trình huấn luyện mô hình o1 mới được OpenAI ra mắt. Những kỹ thuật huấn luyện này, theo họ, có thể thay đổi cuộc chạy đua AI toàn cầu, cũng như thay đổi được cả nhu cầu hiệu năng xử lý của data center, nhu cầu chip xử lý và cả nhu cầu năng lượng để vận hành những data center khổng lồ.

Đại diện của OpenAI thì từ chối bình luận về việc họ đã ứng dụng giải pháp huấn luyện mô hình ngôn ngữ mới như thế nào.

Để dễ hiểu thì 2 năm qua, kể từ khi ChatGPT chính thức ra mắt tháng 11/2022, giải pháp cơ bản để tạo ra những mô hình ngôn ngữ với lượng tham số càng lúc càng cao là đẩy quy mô phần cứng máy chủ đám mây dùng trong quá trình huấn luyện và vận hành mô hình. Hiệu năng xử lý của máy chủ đám mây tăng theo tỷ lệ thuận với lượng dữ liệu các nhà nghiên cứu và các kỹ sư AI cần để huấn luyện mô hình mới, để thuật toán machine learning học được những nội dung do con người tạo ra.

Nhưng hiện giờ, nhiều nhà nghiên cứu AI đã đề xuất những giải pháp mới, và cách huấn luyện mô hình AI theo kiểu “lớn hơn là tốt hơn” giờ không còn hợp thời nữa.

Ilya Sutskever, đồng sáng lập OpenAI, người từng nắm vị trí giám đốc khoa học startup này, hiện tại đang sáng lập và làm việc cho Safe Superintelligence gần đây trả lời phỏng vấn Reuters, rằng giải pháp phổ biến hiện giờ đã có dấu hiệu chững lại. Giải pháp này là mở rộng quy mô quá trình pre-training, sử dụng dữ liệu huấn luyện do con người tạo ra, nhưng không đánh dấu nội dung, để mô hình AI hiểu kết cấu và mẫu của từng loại ngôn ngữ tự nhiên.

Ở thời điểm sáng lập và làm việc cho OpenAI, Sutskever chính là người mở ra định hướng mở rộng quy mô huấn luyện ở bước pre-training, với lượng dữ liệu khổng lồ dạy cho mô hình AI hiểu cách ngôn ngữ kết cấu ra sao: “Những năm cuối thập niên 2010 chính là thời điểm các nhà nghiên cứu đẩy quy mô huấn luyện mô hình AI lên ngưỡng cực đại. Còn bây giờ chúng ta lại quay về thời điểm tìm hiểu và thử nghiệm, khám phá lại từ đầu. Ai cũng đang tìm kiếm bước đi kế tiếp. Đẩy quy mô nghiên cứu đúng đắn là thứ quan trọng hơn bao giờ hết.”

Tuy nhiên, Sutskever lại bảo vệ bí mật nghiên cứu và kinh doanh bằng cách từ chối trả lời câu hỏi của Reuters về việc SSI đã và đang làm gì để vượt qua giới hạn của kỹ thuật huấn luyện mô hình AI hiện tại.

Cũng vì những giới hạn của quá trình pre-training, không thể cứ ném dữ liệu và hiệu năng xử lý của máy chủ vào mô hình AI mới nữa, nên các nhà nghiên cứu tại các lab phát triển AI hàng đầu thế giới hiện giờ đang phải trì hoãn ra mắt nhiều mô hình mới. Hầu hết chúng đều lấy GPT-4, ra mắt gần 2 năm về trước, làm hệ quy chiếu so sánh.

Những quá trình huấn luyện mô hình AI dưới dạng pre-training có thể ngốn của các startup và đơn vị nghiên cứu AI hàng chục triệu USD chi phí vận hành, bằng cách cho chạy trên những máy chủ với hàng trăm chip xử lý AI cao cấp. Rồi quá trình ấy cũng phải mất vài tháng. Trong suốt quá trình pre-training, nếu có vấn đề xảy đến với mô hình AI, do phần cứng gây ra, thì các nhà nghiên cứu AI cũng không có cách nào phát hiện ra sớm để điều chỉnh lại, từ đó cải thiện hiệu quả nội suy của mô hình AI.

Vấn đề thứ ba, là lượng dữ liệu khổng lồ cần để thực hiện quá trình pre-training. Hiện giờ nội dung văn bản và ngôn ngữ tự nhiên do con người tạo ra đã được sử dụng gần hết. Rất có thể trong tương lai những mô hình AI mới sẽ được huấn luyện dựa trên dữ liệu phái sinh do AI tạo ra và tổng hợp lại.

Vấn đề thứ 4 là nhu cầu điện năng. Một data center với hàng trăm GPU vận hành đồng thời ngốn rất nhiều điện.

Để giải quyết những vấn đề kể trên, các nhà nghiên cứu đã nghĩ ra một giải pháp mới gọi là “test-time compute”. Kỹ thuật này cải thiện sức mạnh của những mô hình AI đang có, tăng hiệu năng và chất lượng nội dung mà AI tạo ra trong quá trình nội suy. Lấy ví dụ, thay vì ngay lập tức chọn ra 1 câu trả lời cho prOmpt của anh em, AI sẽ tạo ra và cân nhắc vài kết quả theo thời gian thực, rồi chọn ra câu trả lời mà nó nghĩ là tốt nhất.

Giải pháp này cho phép những mô hình AI dành ra sức mạnh xử lý nội suy để giải quyết những nhiệm vụ khó như giải toán hay lập trình, hoặc những nhiệm vụ phức tạp, đòi hỏi tư duy lý lẽ, mục tiêu ban đầu của các nhà phát triển AI, bắt thuật toán và máy móc suy nghĩ như não bộ con người.

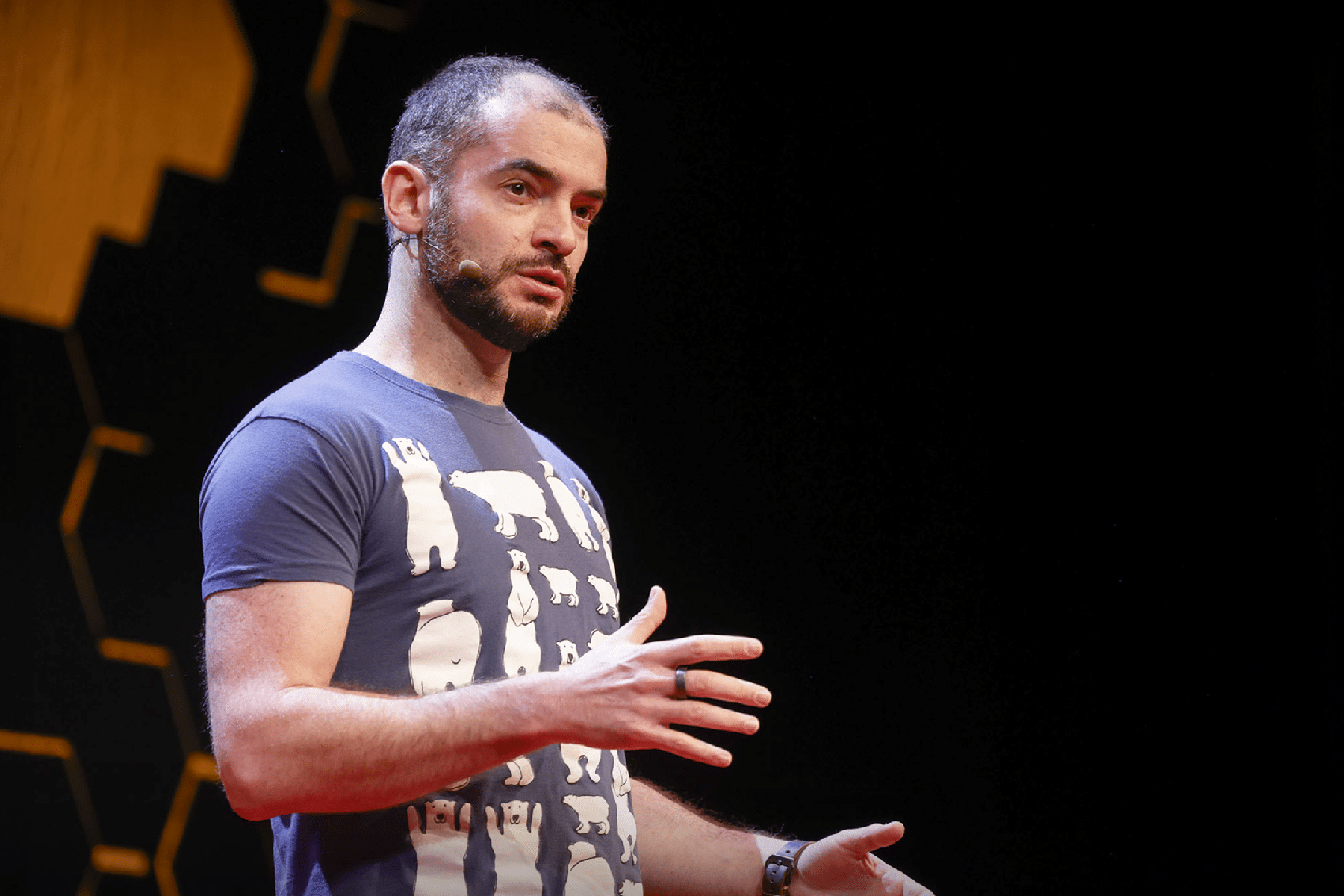

Noam Brown, một nhà nghiên cứu tại OpenAI, người góp công sức phát triển o1 tháng trước đã có bài thuyết trình tại TED AI tổ chức ở San Francisco, Mỹ: “Hóa ra để một mô hình AI nghĩ 20 giây để giải quyết một vấn đề tạo ra hiệu năng tương đương với việc mở rộng quy mô tham số mô hình lên 100 nghìn lần, và huấn luyện nó trong khoảng thời gian lâu hơn 100 nghìn lần.” o1 có hiệu năng ấn tượng nhờ vào việc nó được huấn luyện thêm, bên cạnh quá trình huấn luyện với mô hình gốc, GPT-4.

Dự kiến, những mô hình lớn trong tương lai sẽ được OpenAI ứng dụng giải pháp huấn luyện tương tự.

Cùng lúc, Anthropic, xAI và DeepMind cũng được cho là đang phát triển giải pháp tương tự như của OpenAI.

Như đã nói, giải pháp huấn luyện mô hình AI mới hoàn toàn có thể thay đổi thị trường máy chủ đám mây và thị trường GPU máy chủ phục vụ xử lý AI. Hiện giờ những con chip của Nvidia, hay mới đây có MI325X của AMD đang là những món hàng được cả thế giới săn lùng. Các quỹ đầu tư thì chi mạnh tay để các đơn vị máy chủ đám mây mới vay tiền mua GPU phục vụ các tập đoàn công nghệ.