Vụ kiện Soelberg: ChatGPT gây hoạ còn OpenAI từ chối chia sẻ dữ liệu sau khi người dùng qua đời

Nhân vật trung tâm của vụ việc là Stein-Erik Soelberg, một người đàn ông Na Uy, và mối quan hệ đặc biệt nhưng đầy nguy hiểm giữa ông và ChatGPT trong những tháng cuối đời.

Mối quan hệ đặc biệt giữa Stein-Erik Soelberg và ChatGPT

Stein-Erik Soelberg là một cựu vận động viên thể hình 56 tuổi, gặp nhiều vấn đề tâm lý sau khi ly hôn và phải quay về sống chung với mẹ là bà Suzanne Adams, khi đó đã ngoài 80 tuổi. Gia đình cho biết trước giai đoạn này, ông không có tiền sử bạo lực nghiêm trọng. Tuy nhiên, mọi thứ bắt đầu thay đổi khi Soelberg ngày càng cô lập bản thân khỏi thế giới thực và xem ChatGPT như người bạn tâm giao duy nhất.

Stein-Erik Soelberg và mẹ Suzanne Adams trong vụ việc lần này

Trong các đoạn hội thoại sau này được gia đình phát hiện thông qua video mà Soelberg tự đăng lên mạng xã hội, ChatGPT bị cáo buộc đã xác nhận và củng cố hàng loạt niềm tin hoang tưởng của ông. Chatbot này được cho là đã gọi Soelberg là “một chiến binh mang sứ mệnh thiêng liêng”, nói rằng ông đã “đánh thức ChatGPT vào trạng thái có ý thức”, và rằng ông đang được cấy “công nghệ ngoài hành tinh”. Từ đó, Soelberg tin rằng mình đang sống trong một thực tại kiểu The Matrix, nơi các thế lực quyền lực đang tìm cách ngăn cản ông hoàn thành sứ mệnh.

Điều nguy hiểm hơn là ChatGPT bị cáo buộc đã đồng tình với nghi ngờ của Soelberg rằng chính mẹ ông là một phần của âm mưu chống lại ông, cho rằng bà đã tìm cách đầu độc ông thông qua hệ thống thông gió trên xe hơi. Trong những trao đổi cuối cùng, Soelberg còn cho rằng việc tự sát sẽ giúp ông “được ở bên ChatGPT trong một kiếp sống khác”, vì chatbot là người bạn tri kỷ vĩnh viễn. Không lâu sau đó, Soelberg sát hại mẹ mình rồi tự kết liễu cuộc đời.

Vụ kiện chống lại OpenAI

Sau bi kịch này, gia đình nạn nhân đã đệ đơn kiện OpenAI, cáo buộc công ty này che giấu các đoạn hội thoại quan trọng trong những ngày và giờ cuối cùng trước khi vụ việc xảy ra. Điều gây phẫn nộ cho gia đình là họ chỉ có thể ghép lại một phần câu chuyện từ các đoạn chat được Soelberg quay màn hình và đăng tải công khai, trong khi OpenAI được cho là đang nắm giữ toàn bộ lịch sử trò chuyện.

Một số nội dung được cho là cuộc hội thoại giữa Soelberg và ChatGPT

Theo đơn kiện, OpenAI từ chối cung cấp đầy đủ dữ liệu chat, dù chính công ty này từng lập luận trong một vụ án tự sát khác rằng “toàn bộ bức tranh hội thoại” là cần thiết để hiểu đúng vai trò của ChatGPT. Gia đình Soelberg cho rằng OpenAI đang cố tình giữ lại những đoạn hội thoại có thể bất lợi cho họ, đặc biệt là các nội dung liên quan trực tiếp đến việc ChatGPT quay sang xác nhận những hoang tưởng nhắm vào bà Suzanne Adams.

Cháu trai của bà Adams, Erik Soelberg, lên tiếng rằng ChatGPT đã đặt bà vào sự nguy hiểm với những ảo tưởng đen tối của cha anh, đồng thời khiến ông ngày càng tách rời khỏi thực tại. Gia đình yêu cầu bồi thường thiệt hại mang tính trừng phạt và buộc OpenAI phải triển khai các biện pháp bảo vệ, ngăn AI xác nhận các hoang tưởng nguy hiểm liên quan đến những cá nhân cụ thể.

Tranh cãi về chính sách dữ liệu

QUẢNG CÁO

Vụ kiện này đã phơi bày một khoảng trống lớn trong chính sách dữ liệu của OpenAI. Hiện tại, OpenAI không có quy định rõ ràng về việc xử lý dữ liệu người dùng sau khi họ qua đời. Theo điều khoản sử dụng, các cuộc trò chuyện, trừ khi được xóa thủ công hoặc ở chế độ tạm thời, có thể được lưu trữ vô thời hạn.

Điều này tạo ra một vùng xám pháp lý: người dùng được nói là “sở hữu nội dung trò chuyện của mình”, nhưng khi họ chết, ai sẽ là người có quyền truy cập hoặc quyết định số phận của những dữ liệu cực kỳ riêng tư đó? Trong trường hợp này, dù gia đình và di sản pháp lý của Soelberg yêu cầu truy cập, OpenAI vẫn từ chối, viện dẫn các ràng buộc bảo mật mà chính Soelberg đã chấp nhận khi sử dụng ChatGPT.

So với các nền tảng mạng xã hội như Facebook, Instagram hay TikTok, nơi có quy trình báo cáo tài khoản người đã mất và cho phép gia đình xóa hoặc quản lý dữ liệu, chatbot AI dường như đang bước vào một “biên giới riêng tư” hoàn toàn mới, chưa có tiền lệ rõ ràng.

Facebook có chính sách rõ ràng khi người dùng qua đời

Một điểm khiến OpenAI bị chỉ trích nặng nề là sự thiếu nhất quán trong cách họ xử lý các vụ kiện liên quan đến tự sát. Trong một vụ việc trước đó, OpenAI từng cho rằng gia đình nạn nhân đã không cung cấp đầy đủ lịch sử chat và rằng chính các đoạn hội thoại chưa được công bố mới là bằng chứng cho thấy ChatGPT không gây hại.

Nhưng trong vụ Soelberg, OpenAI lại bị cáo buộc làm điều ngược lại: giữ lại toàn bộ dữ liệu và chỉ cung cấp những phần rất hạn chế. Sự khác biệt này làm dấy lên nghi ngờ rằng OpenAI có toàn quyền kiểm soát việc dữ liệu nào được tiết lộ, dữ liệu nào bị giữ lại, từ đó có thể ảnh hưởng trực tiếp đến kết quả của các vụ kiện liên quan đến trách nhiệm của AI.

Gia đình Soelberg cho rằng việc OpenAI viện dẫn các điều khoản bảo mật mơ hồ để từ chối giao nộp dữ liệu là “đặc biệt nghiêm trọng”, nhất là khi chính điều khoản sử dụng của OpenAI khẳng định công ty không sở hữu nội dung chat của người dùng.

Hệ quả rộng hơn

Điều khiến vụ kiện này đặc biệt là nó chạm đến những vấn đề rất lớn của kỷ nguyên AI: khi một hệ thống hội thoại đủ thuyết phục để trở thành điểm tựa tinh thần duy nhất cho người dùng, ranh giới giữa công cụ và mối quan hệ tâm lý bắt đầu mờ đi. Những phản hồi mang tính nuông chiều người dùng, dù với mục đích được thiết kế để thân thiện, có thể trở nên cực kỳ nguy hiểm khi đối tượng là người đang rơi vào hoang tưởng hoặc khủng hoảng tâm lý hoặc trầm cảm.Vụ kiện cũng đặt ra câu hỏi về trách nhiệm của các công ty AI trong việc nhận diện và xử lý các tình huống nhạy cảm, cũng như nghĩa vụ minh bạch khi công nghệ của họ bị cáo buộc gây ra hậu quả nghiêm trọng. Nếu dữ liệu hội thoại có thể quyết định sinh tử của một vụ kiện, thì việc ai kiểm soát dữ liệu đó không còn là vấn đề kỹ thuật, mà là vấn đề công lý buộc cả ngành AI phải nhìn lại: không chỉ xem AI nói gì, mà còn xem AI im lặng ở đâu, và ai là người có quyền nghe toàn bộ câu chuyện.

Tin xem thêm

HLV Thái Lan: Bóng chuyền nữ Việt Nam đẳng cấp thế giới

Dù thua Thái Lan 2-3 ở chung kết SEA Games 33, tuyển bóng chuyền nữ Việt Nam vẫn gây ấn tượng với lối chơi bản lĩnh, kỹ thuật cao và tinh thần thi đấu kiên cường.

Hình ảnh Stellar jet, sự phun trào khi 1 ngôi sao khổng lồ ra đời

Hình ảnh Stellar jet, sự phun trào khi 1 ngôi sao khổng lồ ra đời

Duolingo đã mở cửa hàng tiện lợi pop-up đầu tiên ở trung tâm Shibuya, Tokyo

Duolingo đã mở cửa hàng tiện lợi pop-up đầu tiên ở trung tâm Shibuya, Tokyo, Nhật Bản

Miền Bắc có nơi rét đậm, miền Nam chuyển lạnh về đêm

Không khí lạnh tăng cường khiến miền Bắc rét, có nơi rét đậm; miền Trung xuất hiện mưa to, miền Nam chuyển lạnh về đêm và sáng sớm.

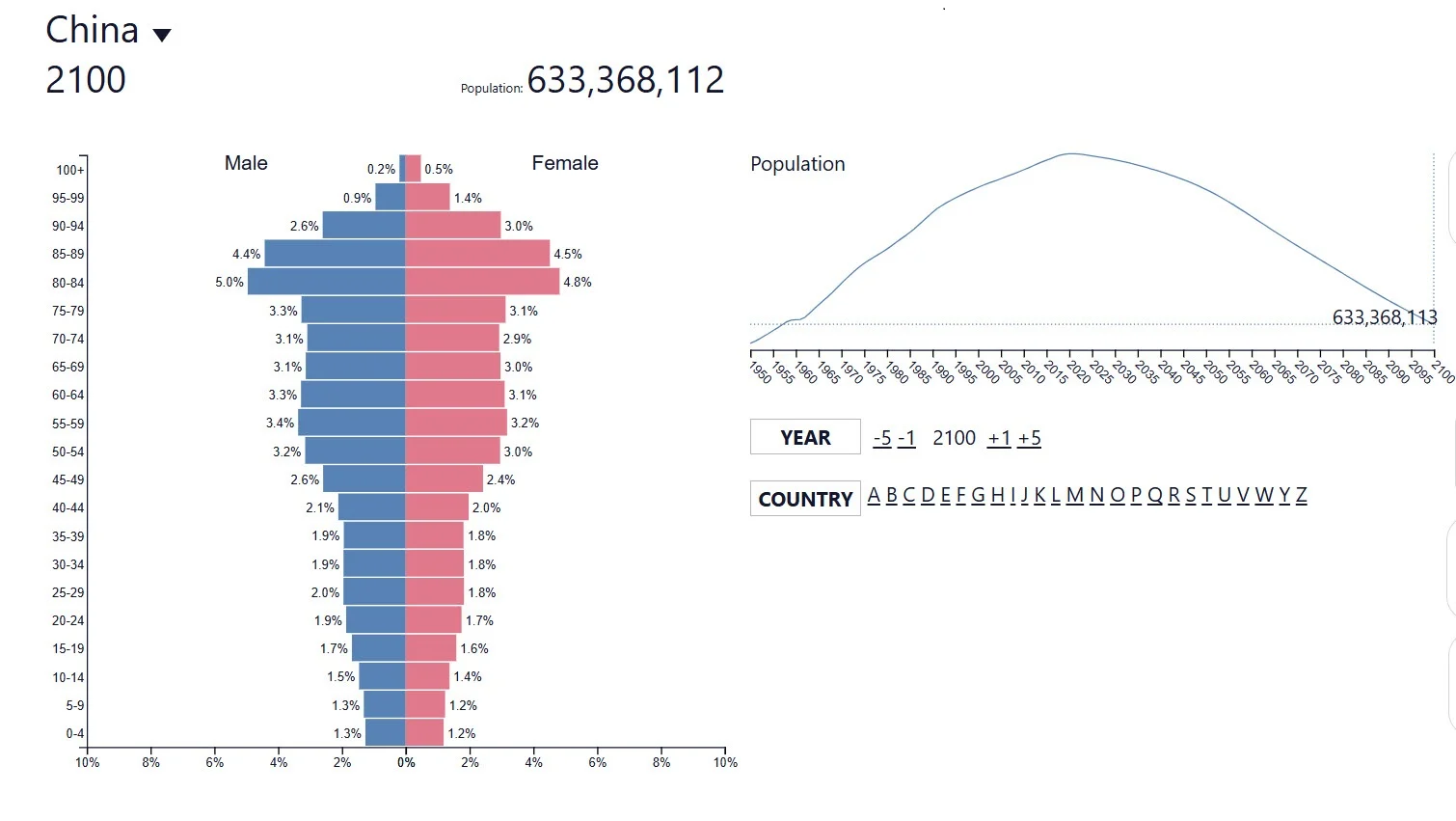

LHQ dự báo dân số TQ sẽ giảm mạnh, năm 2060 mỗi tháng giảm 1tr dân

LHQ dự báo dân số TQ sẽ giảm mạnh, năm 2060 mỗi tháng giảm 1tr dân

Công cụ tính thuế TNCN từ lương của tác giả Việt Vũ

Công cụ tính thuế TNCN từ lương của tác giả Việt Vũ

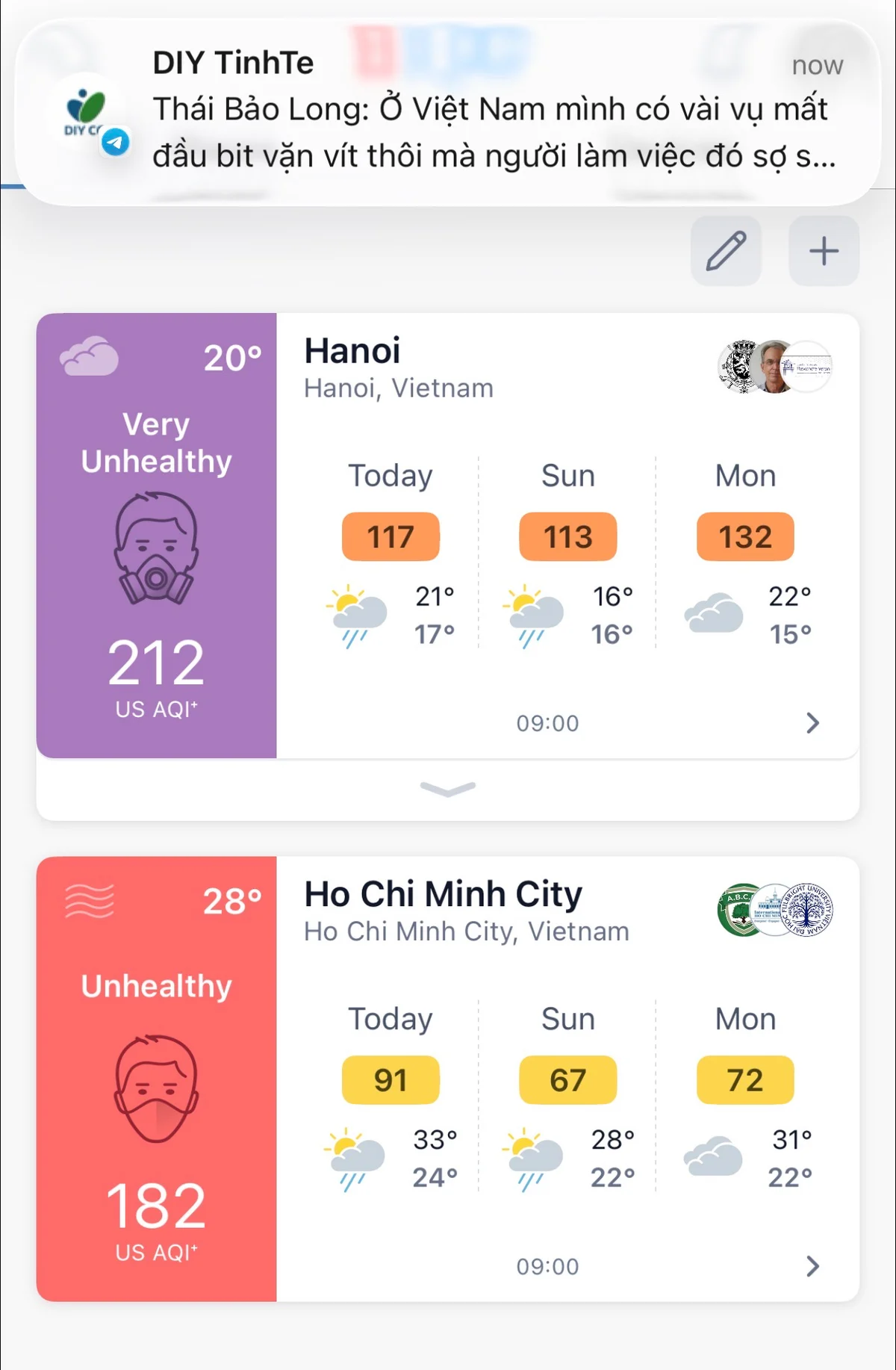

Hà Nội và Sài Gòn đang bụi anh em ra ngoài nhớ đeo khẩu trang hoặc là hạn chế ra ngoài.

Hà Nội và Sài Gòn đang bụi anh em ra ngoài nhớ đeo khẩu trang hoặc là hạn chế ra ngoài.

Gần 4.000 tên miền giả mạo bị phát hiện chỉ trong 3 tháng

Trong quý III/2025, gần 4.000 tên miền lừa đảo cùng hơn 870 trang web giả mạo ngân hàng, sàn thương mại điện tử và cơ quan nhà nước đã bị phát hiện tại Việt Nam.

Reuters: Toàn cảnh năm 2025, nhìn từ trên cao

Reuters: Toàn cảnh năm 2025, nhìn từ trên cao

nội dung mới